Digitální transformace je horkým tématem pro všechny trhy a průmyslová odvětví, protože přináší hodnotu s explozivním tempem růstu. Vezměme si, že průmyslový internet věcí (IIOT) výrobního průmyslu byl oceněn na 161 miliard USD s působivým 25% tempem růstu, trh Connected Car bude do roku 2027 oceněn na 225 miliard USD s tempem růstu 17 %, nebo že v prvních třech měsících roku V roce 2020 maloobchodníci uskutečnili deset let penetrace digitálního prodeje za pouhé tři měsíce. Většina toho, co je napsáno, má však co do činění s platformami umožňujícími technologie (cloudová nebo okrajová nebo bodová řešení, jako jsou datové sklady) nebo případy použití, které tyto výhody pohánějí (prediktivní analytika aplikovaná na preventivní údržbu, odhalování podvodů finanční instituce nebo prediktivní monitorování zdraví). jako příklady), nikoli podkladová data. Chybějící kapitola není o bodových řešeních nebo cestě zralosti případů užití. Chybějící kapitola je o datech – je to vždy o datech – a co je nejdůležitější, data cesty se prolínají od okraje k náhledu umělé inteligence.

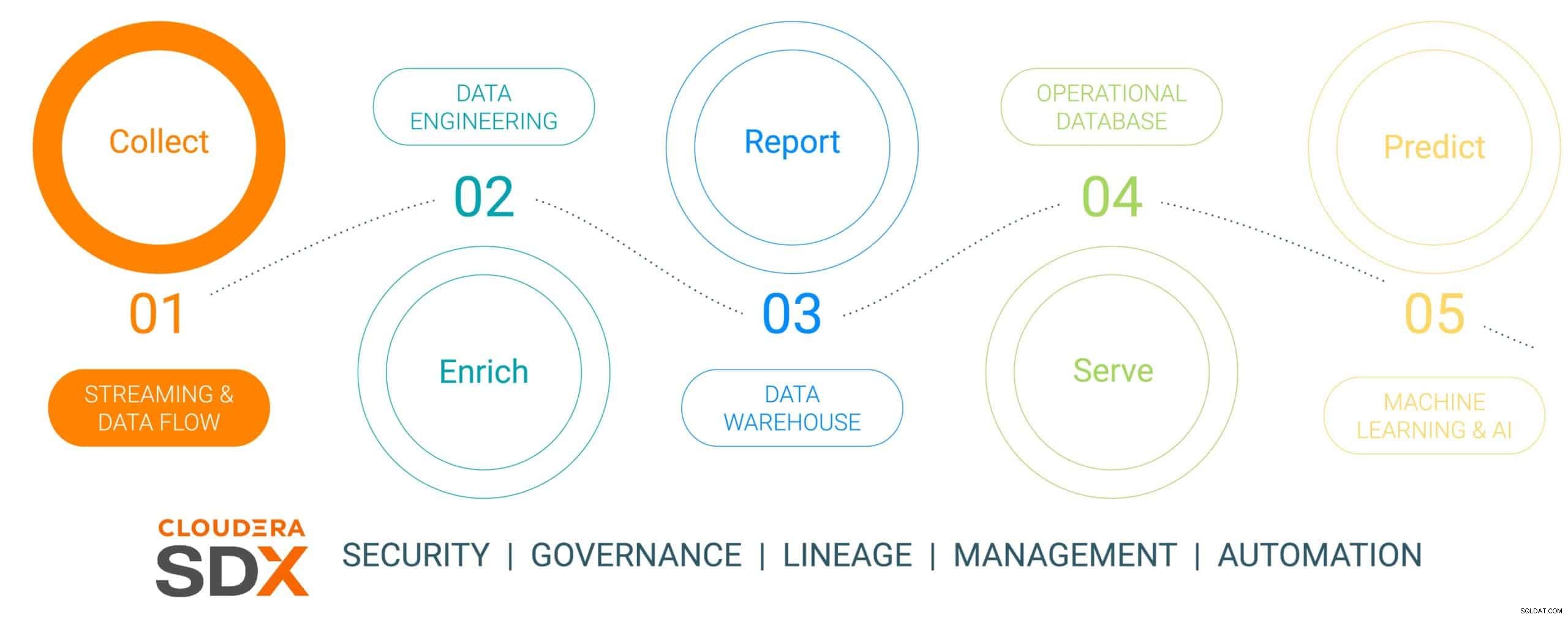

Toto je první ze šestidílné série blogů, která nastiňuje cestu dat od okraje k AI a data o obchodní hodnotě, která na této cestě vytvářejí. Cesta dat není lineární, ale je to nekonečná smyčka životního cyklu dat – začíná na okraji, proplétá se datovou platformou a vede k obchodním imperativům aplikovaným na skutečné kritické problémy, které vedou k novým iniciativám založeným na datech. Zjednodušili jsme tuto cestu do pěti samostatných kroků se společným šestým krokem, který hovoří o zabezpečení a správě dat. Těchto šest kroků je:

- Shromažďování dat – příjem a monitorování dat na okraji (ať už jde o průmyslové senzory nebo lidi v kamenné prodejně)

- Obohacení dat – zpracování datového kanálu, agregace a správa pro přípravu dat k dalšímu zpřesnění

- Hlášení – poskytování informací o podnikání (analýza a prognózování prodeje, průzkum trhu, rozpočtování jako příklady)

- Poskytování – řízení a řízení základních obchodních operací (bankomatové transakce, maloobchodní pokladna nebo sledování výroby)

- Predictive Analytics – prediktivní analytika založená na AI a strojovém učení (detekce podvodů, prediktivní údržba, optimalizace zásob na základě poptávky jako příklady)

- Zabezpečení a správa – integrovaná sada technologií zabezpečení, správy a správy v rámci celého životního cyklu dat

Obr 1:Životní cyklus podnikových dat

Pro ilustraci datové cesty jsme zvolili velmi relevantní a udržitelně smýšlející výrobní téma – výrobu elektromobilu, kterou jsme zvolili proto, že výrobní operace jsou obvykle revoluční povahy (vysoká digitální vyspělost využívající nejmodernější datové nástroje) , ve srovnání s „old-school evoluční“ (nižší vyspělosti) a že většina těchto vozů je postavena jako platformy Connected Mobility, díky nimž je auto více než jen přeprava, ale platforma pro znalosti a náhled na data. Tento příběh ukáže, jak jsou data shromažďována, obohacována, ukládána, poskytována a následně používána k předpovídání událostí ve výrobním procesu vozu pomocí Cloudera Data Platform.

Tento příběh bude představovat falešnou společnost vyrábějící elektromobily propojená vozidla s názvem (s velmi originálním názvem) The Electric Car Company (ECC). ECC provozuje několik výrobních závodů rozmístěných po celém světě, je vertikálně integrovaná a vyrábí vlastní vozy i mnoho kritických komponent, včetně elektromotorů, baterií a pomocných dílů. Každá továrna je pověřena výrobou různých součástí, přičemž konečná montáž probíhá v několika vybraných, strategicky umístěných továrnách.

Výzva ke shromažďování dat

Řízení sběru všech dat ze všech továren ve výrobním procesu je významným úkolem, který představuje několik výzev:

- Potíže s hodnocením objemu a rozmanitosti dat IoT: Mnoho továren využívá moderní i starší výrobní prostředky a zařízení od různých dodavatelů s různými protokoly a datovými formáty. Přestože ovladače a zařízení mohou být připojeny k systému OT, obvykle nejsou připojeny tak, aby mohly snadno sdílet data také s IT systémy. Aby bylo možné umožnit propojenou výrobu a nově vznikající případy použití IoT, potřebuje ECC řešení, které dokáže zpracovat všechny typy různorodých datových struktur a schémat od okraje, normalizovat data a poté je sdílet s jakýmkoli typem spotřebitele dat, včetně aplikací Big Data.

- Správa složitosti dat v reálném čase: Aby mohlo ECC podporovat případy použití prediktivní analýzy, platforma pro správu dat musí umožňovat analýzu streamovaných dat v reálném čase. Platforma také potřebuje efektivně přijímat, ukládat a zpracovávat streamovaná data v reálném čase nebo téměř v reálném čase, aby mohla okamžitě poskytovat přehledy a akce.

- Uvolnění dat z nezávislých sil: Specializované procesy (inovační platformy, QMS, MES atd.) v rámci výrobního hodnotového řetězce odměňují různorodé zdroje dat a platformy pro správu dat, které jsou přizpůsobeny jedinečným siled řešením. Tato specializovaná řešení omezují hodnotu podniku, berou v úvahu pouze zlomek přehledu, který mohou nabídnout mezipodniková data, a zároveň rozdělují podnikání a omezují možnosti spolupráce. Správná platforma musí mít schopnost ingestovat, ukládat, spravovat, analyzovat a zpracovávat streamovaná data ze všech bodů v hodnotovém řetězci, kombinovat je s datovými historiky, ERP, MES a QMS zdroji a využívat je k použitelným poznatkům. Tyto poznatky budou poskytovat řídicí panely, sestavy a prediktivní analýzy, které vedou k vysoce hodnotným případům použití ve výrobě.

- Vyvážení okraje: Pochopení správné rovnováhy mezi zpracováním dat na okraji a v cloudu je výzvou, a proto je třeba zvážit celý životní cyklus dat. V tomto odvětví existuje znepokojivý trend, protože společnosti se rozhodnou zaměřit se na jedno nebo druhé, aniž by si uvědomily, že mohou a měly by dělat obojí. Cloud computing má své výhody pro dlouhodobou analýzu a rozsáhlé nasazení, ale je omezený šířkou pásma a často shromažďuje obrovské množství dat, přičemž využívá pouze malou část. Hodnota edge spočívá v tom, že působí na okraji, kde má největší dopad s nulovou latencí, než odešle nejcennější data do cloudu k dalšímu vysoce výkonnému zpracování.

Sběr dat pomocí datové platformy Cloudera

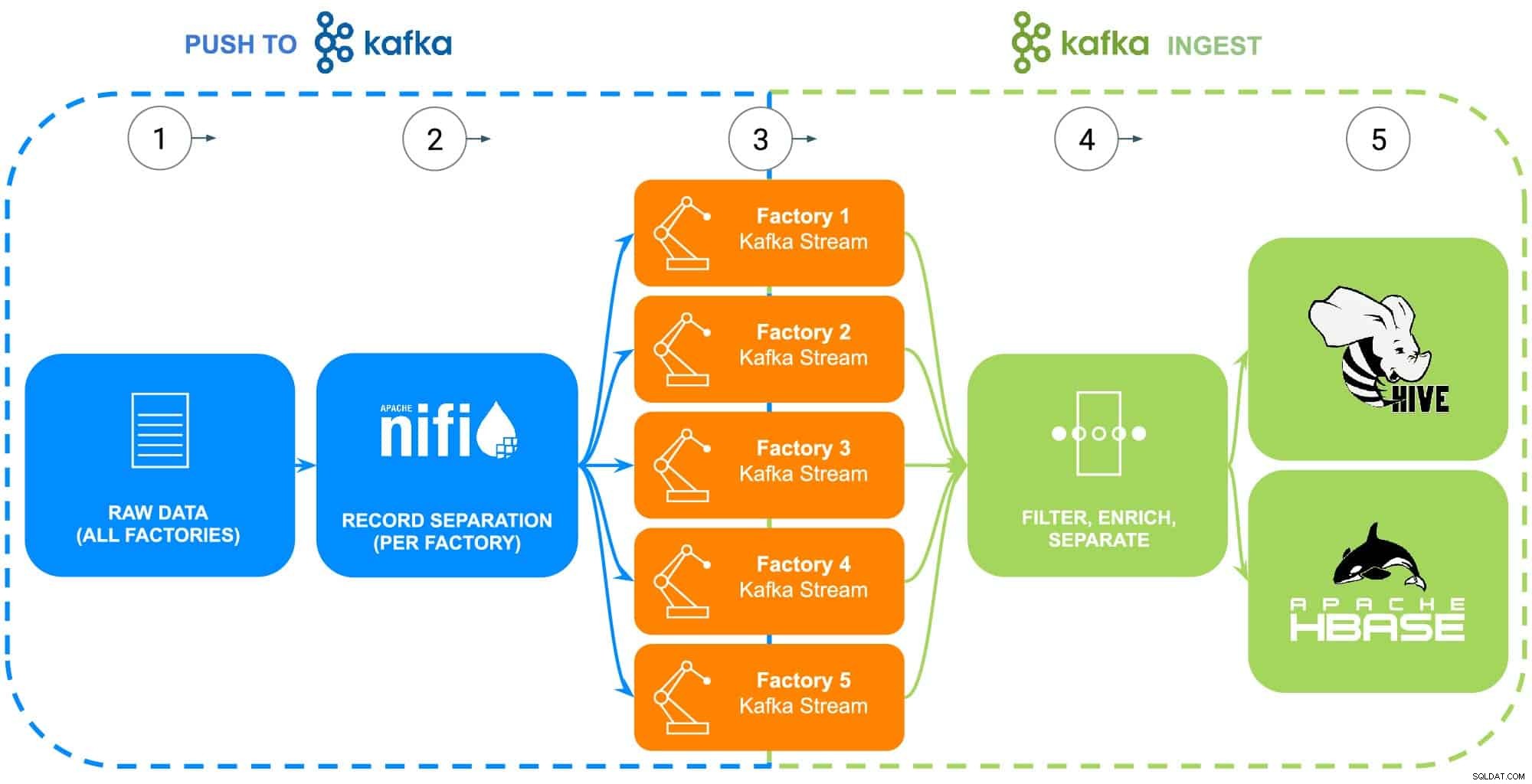

KROK 1:Sběr nezpracovaných dat

Data z výrobního provozu ECC zahrnují velké množství zdrojů – průmyslové roboty, procesní nádrže s fosfátovým potahováním karoserie (teplota, koncentrace nebo doplňování), telematika dodavatelského řetězce nebo informace o hlavním dílu atd. Pro tento konkrétní příklad je surový díl kmenová data pro každou z pěti továren ECC byla shromážděna v rámci přípravy na zavádění do Apache NiFi (viz obr. 2).

KROK 2:Nakonfigurujte zdroje dat pro každou továrnu

Shromažďování dat bude ilustrováno pomocí zkušeností Cloudera Data Flow (využívá Apache NiFi) k získání těchto nezpracovaných dat a jejich rozdělení do jednotlivých továrních toků (spravovaných Apache Kafka), aby se přesněji podobaly scénáři reálného světa (viz obr. 2). Aby byl příklad jednoduchý, byly pro každou součást generovanou továrnami vybrány následující značky atributů dat:

- Tovární ID

- ID stroje

- Časové razítko výroby

- Číslo dílu

- Sériové číslo

Obr. 2:Vývojový diagram sběru dat.

KROK 3:Sledujte propustnost dat z každé továrny

Se všemi daty, která nyní proudí do jednotlivých toků Kafka, datový architekt sleduje propustnost dat z každé továrny a také upravuje výpočetní a úložné zdroje potřebné k tomu, aby se ujistil, že každá továrna má požadovanou propustnost pro odesílání dat do platformy.

KROK 4:Zachyťte data ze streamů Apache Kafka

Kafka zachycuje všechny toky továrních dat a shromažďuje je do procesorů, které budou filtrovat a obohacovat pro použití při řízení a provozování základních obchodních operací poháněných provozní databází nebo poskytováním podnikového náhledu prostřednictvím podnikového datového skladu nebo využívaným v pokročilé analýze.

Společnost ECC nedávno zahájila výrobu vylepšené verze svého elektromotoru, který se vyrábí pouze v továrně 5, tato data budou použita jako ilustrace dalších kroků v životním cyklu dat

KROK 5:Odeslání dat do řešení úložiště

Vzhledem k tomu, že inženýři výroby a kvality ECC budou chtít pečlivě sledovat nasazení a použití tohoto motoru v terénu, jsou specifická data sledovatelnosti výroby filtrována do samostatné trasy a uložena do vlastní tabulky v Apache Hive. To inženýrům umožní spouštět ad-hoc dotazy v Cloudera Data Warehouse proti datům později a také je spojovat s dalšími relevantními daty v podnikovém datovém skladu, jako jsou objednávky na opravy nebo zpětná vazba od zákazníků, a vytvářet tak pokročilé případy použití, jako je záruka, prediktivní rutiny údržby nebo vstupy do vývoje produktu.

Alternativně, pokud je požadováno řízení a řízení základních obchodních operací, bude celá datová sada s přidáním zpracovaného časového razítka odeslána do provozní databáze Cloudera poháněné Apache HBase. Tato data budou sloužit jako základ pro ECC pro provoz jejich inventární platformy, která bude vyžadovat použití neustálých operací čtení/zápisu, protože inventář lze přidávat i odebírat tisíckrát za den. Vzhledem k tomu, že HBase je navržen pro zpracování těchto druhů datových transakcí ve velkém měřítku, slouží jako nejlepší řešení pro tuto jedinečnou výzvu.

Závěr

Tato jednoduchá ilustrace ukazuje důležitost správného zpracování dat, protože je základem pro poznatky získané z provozních databází, podnikových datových skladů nebo pokročilé analytické prediktivní analýzy strojového učení. Hodnota „uvedení do pořádku“ zahrnuje použití dat z jakéhokoli podnikového zdroje, čímž se rozloží datová sila, využití všech dat, ať už se jedná o streamování nebo dávkové orientace, a možnost odeslat tato data na správné místo a vytvořit tak požadovaný přehled.

Pomocí CDP mohou datoví inženýři ECC a další obchodní uživatelé začít používat shromážděná data pro různé úkoly, od správy zásob přes prognózování dílů až po strojové učení. Vzhledem k tomu, že Cloudera Data Flow podporuje příjem dat v reálném čase z jakéhokoli podnikového zdroje, lze jej rozšiřovat a udržovat bez rozsáhlých znalostí různých programovacích jazyků a proprietárních metod sběru dat. Pokud se vyskytnou jedinečné problémy, mohou inženýři také vytvořit své vlastní procesy pro skutečně jemnou kontrolu.

Podívejte se na další blog, který se bude ponořit do obohacování dat a jak podporuje příběh životního cyklu dat. Tento příběh bude navíc rozšířen o ukázky založené na datech, které ukazují cestu dat každým krokem životního cyklu dat.

Další zdroje shromažďování dat

Chcete-li toto vše vidět v akci, klikněte na související odkazy níže a získejte další informace o sběru dat:

- Video – Pokud chcete vidět a slyšet, jak to bylo postaveno, podívejte se na video pod odkazem.

- Výukové programy – Pokud to chcete udělat svým vlastním tempem, prohlédněte si podrobný návod se snímky obrazovky a pokyny po řádcích, jak to nastavit a spustit.

- Meetup – Pokud si chcete promluvit přímo s odborníky z Cloudera, připojte se k virtuálnímu setkání a podívejte se na živý přenos prezentace. Na konci bude čas na přímé otázky a odpovědi.

- Uživatelé – Chcete-li zobrazit více technického obsahu specifického pro uživatele, klikněte na odkaz.