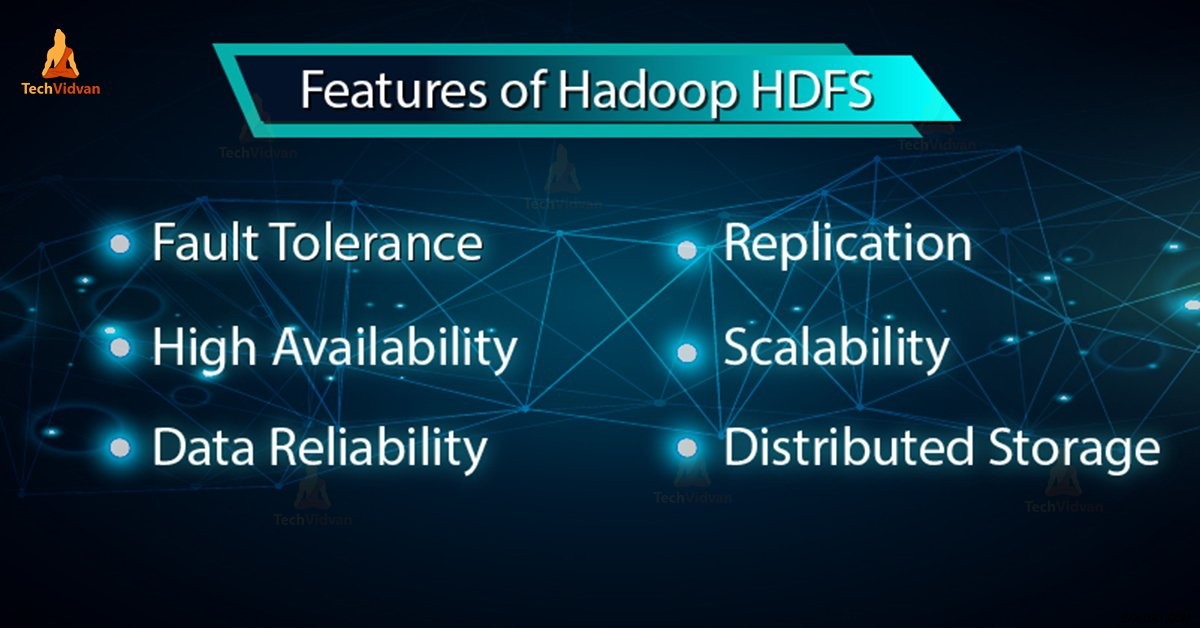

V našem předchozím blogu jsme se naučili Hadoop HDFS podrobně se nyní v tomto blogu budeme zabývat funkcemi HDFS. Hadoop HDFS má funkce jako odolnost proti chybám, replikace, spolehlivost, vysoká dostupnost, distribuované úložiště, škálovatelnost atd.

Všechny tyto funkce HDFS v Hadoopu budou diskutovány v tomto tutoriálu Hadoop HDFS.

Úvod do Hadoop HDFS

Distribuovaný systém souborů Hadoop (HDFS) je primární úložný systém Hadoop. Ukládá velmi velké soubory běžící na clusteru komoditního hardwaru. HDFS je založen na GFS (Google FileSystem). Spolehlivě ukládá data i v případě selhání hardwaru.

HDFS také poskytuje vysoce propustný přístup k aplikaci prostřednictvím paralelního přístupu. Podle předpovědi do konce roku 2017 bude 75 % dat dostupných na planetě umístěno v HDFS.

6 důležitých funkcí HDFS

Po prostudování úvodu Hadoop HDFS si nyní proberme nejdůležitější funkce HDFS.

1. Odolnost proti chybám

Odolnost proti chybám v Hadoop HDFS je pracovní síla systému v nepříznivých podmínkách. Je vysoce odolný proti chybám. Hadoop framework rozděluje data do bloků. Poté vytvoří více kopií bloků na různých počítačích v clusteru.

Když se tedy některý počítač v clusteru porouchá, klient může snadno přistupovat ke svým datům z druhého počítače, který obsahuje stejnou kopii datových bloků.

2. Vysoká dostupnost

Hadoop HDFS je vysoce dostupný systém souborů. V HDFS se data replikují mezi uzly v clusteru Hadoop vytvořením repliky bloků na ostatních podřízených zařízeních přítomných v clusteru HDFS. Kdykoli tedy uživatel chce získat přístup k těmto datům, může ke svým datům přistupovat z podřízených jednotek, které obsahují jeho bloky.

V době nepříznivých situací, jako je porucha uzlu, může uživatel snadno přistupovat ke svým datům z ostatních uzlů. Protože duplicitní kopie bloků jsou přítomny na ostatních uzlech v clusteru HDFS.

3. Vysoká spolehlivost

HDFS poskytuje spolehlivé úložiště dat. Dokáže ukládat data v rozsahu 100 s petabajtů. HDFS spolehlivě ukládá data do clusteru. Rozdělí data do bloků. Rámec Hadoop ukládá tyto bloky na uzlech přítomných v clusteru HDFS.

HDFS ukládá data spolehlivě vytvořením repliky každého bloku přítomného v clusteru. Poskytuje tak možnost odolnosti proti poruchám. Pokud dojde k výpadku uzlu v clusteru obsahujícím data, uživatel může k těmto datům snadno přistupovat z ostatních uzlů.

HDFS ve výchozím nastavení vytváří 3 repliky každého bloku obsahujícího data přítomná v uzlech. Data jsou tak uživatelům rychle dostupná. Uživatel tedy nečelí problému ztráty dat. HDFS je tedy vysoce spolehlivý.

4. Replikace

Replikace dat je jedinečná funkce HDFS. Replikace řeší problém ztráty dat za nepříznivých podmínek, jako je selhání hardwaru, pád uzlů atd. HDFS udržuje proces replikace v pravidelných časových intervalech.

HDFS také neustále vytváří repliky uživatelských dat na různých počítačích přítomných v clusteru. Takže, když některý uzel selže, uživatel může přistupovat k datům z jiných počítačů. Neexistuje tedy žádná možnost ztráty uživatelských dat.

5. Škálovatelnost

Hadoop HDFS ukládá data na více uzlech v clusteru. Takže kdykoli se požadavky zvýší, můžete cluster škálovat. V HDFS jsou k dispozici dva mechanismy škálovatelnosti:Vertikální a Horizontální škálovatelnost.

6. Distribuované úložiště

Všechny funkce v HDFS jsou dosaženy prostřednictvím distribuovaného úložiště a replikace. HDFS ukládá data distribuovaným způsobem mezi uzly. V Hadoopu jsou data rozdělena do bloků a uložena na uzlech přítomných v clusteru HDFS.

Poté HDFS vytvořte repliku každého bloku a uložte na jiné uzly. Když dojde k selhání jednoho počítače v clusteru, můžeme snadno přistupovat k našim datům z ostatních uzlů, které obsahují jeho repliku.

Závěr

Na závěr můžeme říci, že HDFS je vysoce odolný vůči chybám. Spolehlivě ukládá obrovské množství dat i přes selhání hardwaru. Poskytuje také vysokou škálovatelnost a vysokou dostupnost. HDFS tedy umožňuje funkci Hadoop. Pokud najdete nějakou jinou funkci HDFS, podělte se s námi v sekci komentářů níže.