V tomto výukovém programu Hadoop pro velká data , poskytneme vám podrobný popis datového bloku Hadoop HDFS. Nejprve probereme, co je datový blok v Hadoopu, jaký je jeho význam, proč je velikost datových bloků HDFS 128 MB.

Probereme také příklad datových bloků v hadoopu a různé výhody HDFS v Hadoopu.

Úvod do HDFS Data Block

Hadoop HDFS rozdělit velké soubory na malé části známé jako bloky . Blok je fyzická reprezentace dat. Obsahuje minimální množství dat, která lze číst nebo zapisovat. HDFS ukládá každý soubor jako bloky. Klient HDFS nemá žádnou kontrolu nad blokem, jako je umístění bloku, o všech takových věcech rozhoduje Namenode.

Ve výchozím nastavení je velikost bloku HDFS 128 MB které můžete změnit podle svých požadavků. Všechny bloky HDFS mají stejnou velikost kromě posledního bloku, který může být buď stejně velký, nebo menší.

Rámec Hadoop rozdělí soubory na bloky o velikosti 128 MB a poté uloží do systému souborů Hadoop. Aplikace Apache Hadoop je zodpovědná za distribuci bloku dat mezi více uzly.

Příklad-

Předpokládejme, že velikost souboru je 513 MB a používáme výchozí konfiguraci velikosti bloku 128 MB. Potom framework Hadoop vytvoří 5 bloků, první čtyři bloky 128 MB, ale poslední blok bude mít pouze 1 MB.

Z příkladu je tedy zřejmé, že není nutné, aby v HDFS každý uložený soubor byl přesným násobkem nakonfigurované velikosti bloku 128 MB, 256 MB atd. Konečný blok pro soubor tedy využívá pouze tolik místa, kolik je potřeba.

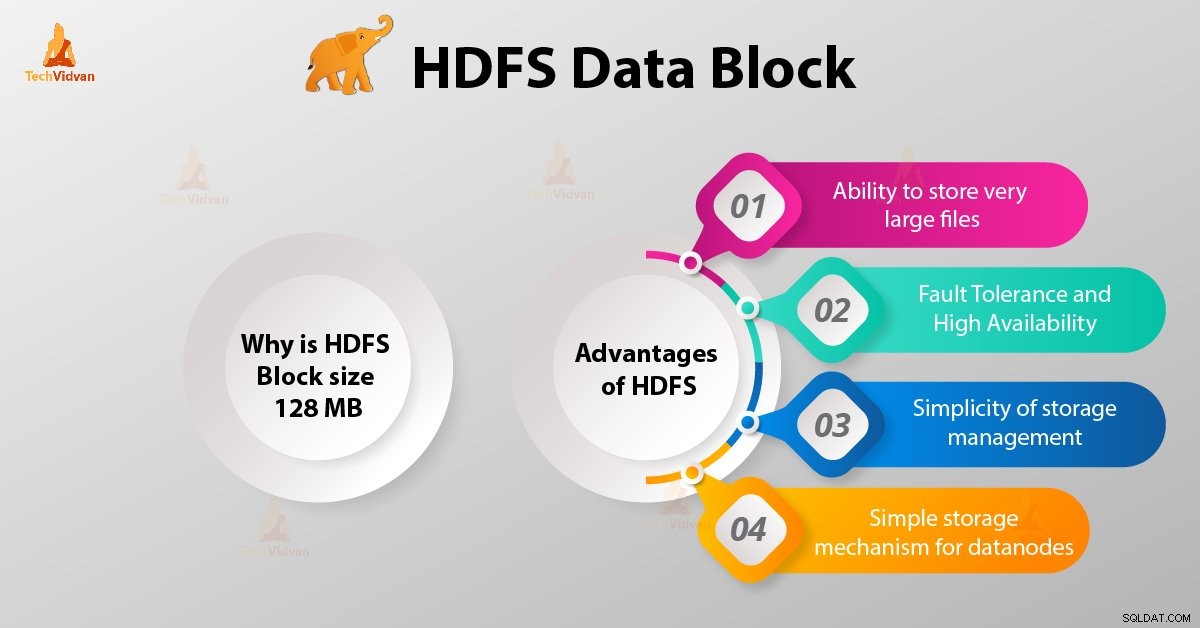

Proč je velikost bloku HDFS 128 MB?

HDFS ukládá terabajty a petabajty dat. Pokud je velikost bloku HDFS 4 kb jako systém souborů Linux, pak budeme mít v Hadoop HDFS příliš mnoho datových bloků, a tudíž příliš mnoho metadat.

Údržba a správa tohoto obrovského množství bloků a metadat tedy vytvoří obrovskou režii a provoz, což je něco, co nechceme.

Velikost bloku nemůže být tak velká, aby systém čekal velmi dlouho na dokončení poslední jednotky zpracování dat.

Výhody HDFS

Poté, co jsme se dozvěděli, co je HDFS Data Block, pojďme nyní diskutovat o výhodách Hadoop HDFS.

1. Možnost ukládat velmi velké soubory

Hadoop HDFS ukládá velmi velké soubory, které jsou dokonce větší než velikost jednoho disku, protože rámec Hadoop rozděluje soubor na bloky a distribuuje mezi různé uzly.

2. Odolnost proti chybám a vysoká dostupnost HDFS

Hadoop framework může snadno replikovat bloky mezi datovými uzly. Zajistěte tak odolnost proti chybám a vysokou dostupnost HDFS.

3. Jednoduchost správy úložiště

Protože HDFS má pevnou velikost bloku (128 MB), je velmi snadné vypočítat počet bloků, které lze uložit na disk.

4. Jednoduchý mechanismus úložiště pro datové uzly

Block in HDFS zjednodušuje ukládáníDatových uzlů . Název udržuje metadata všech bloků. HDFS Datanode se nemusí starat o metadata bloku, jako jsou oprávnění k souborům atd.

Závěr

Datový blok HDFS je tedy nejmenší jednotkou dat v souborovém systému. Výchozí velikost bloku HDFS je 128 MB, kterou můžete nakonfigurovat podle požadavků. Bloky HDFS lze snadno replikovat mezi datovými uzly. Zajistěte tak odolnost proti chybám a vysokou dostupnost HDFS.

V případě jakýchkoli dotazů nebo návrhů souvisejících s datovými bloky Hadoop HDFS nám dejte vědět zanecháním komentáře v sekci níže.